Tema

Este análisis captura lecciones específicas extraídas de la experiencia de nuevos agentes de implementación en el desarrollo de marcos de evaluación de proyectos de prevención de la radicalización violenta a pequeña escala.

Resumen

La prevención de la radicalización violenta (comúnmente expresada en las siglas en inglés P/CVE, por preventing/countering violent extremism) es un campo de investigación y aplicación práctica todavía en proceso de construcción que ha atraído en los últimos años a profesionales de distintos ámbitos –la academia, el sector privado, la seguridad, la sociedad civil y la administración pública– con limitada experiencia directa en este campo. Sus contribuciones al marco europeo de P/CVE se enfrentan al reto de desarrollar una cultura de evaluación que ayude a comprender qué funciona y qué puede mejorarse. Este Documento de Trabajo captura lecciones específicas extraídas de la experiencia de nuevos agentes de implementación en el desarrollo de marcos de evaluación de proyectos P/CVE a pequeña escala. Está basado en evidencia recogida durante el Proyecto EU H2020 MINDb4ACT. Los hallazgos se refieren a tres dimensiones: (1) la conceptualización del proceso (los objetivos de la evaluación); (2) su operacionalización (las herramientas de evaluación); y (3) el análisis (la interpretación y comunicación de resultados).

Análisis

(1) Introducción

El modelo europeo de respuesta a la violencia extremista quedó establecido tras los atentados yihadistas del 7 de julio de 2005 en Londres. La UE aprobó entonces una nueva estrategia que establece la prevención de la radicalización y el reclutamiento como uno de los cuatro pilares de actuación frente al terrorismo, superando así el tradicional enfoque exclusivamente securitario/reactivo en favor de uno que incorpora la perspectiva preventiva/anticipatoria.1 Con el cambio de paradigma llegó también la ampliación progresiva y generalizada del mapa de actores implicados en la lucha contra esa amenaza, dando así entrada a agentes no gubernamentales en un ámbito de actuación hasta entonces reservado a las fuerzas de seguridad, operadores jurídicos y decisores políticos.

El ecosistema europeo de prevención y lucha contra la radicalización violenta (P/CVE en adelante) lo integran desde hace ya más de una década un conjunto heterogéneo de actores (decisores políticos, actores de primera línea, sector privado, investigadores académicos, organizaciones no gubernamentales, fuerzas y cuerpos de seguridad, etc.). Su participación en un campo de investigación e intervención práctica todavía en fase de desarrollo se ha visto favorecido, en buena medida, por los esfuerzos gubernamentales por empoderar a actores de base y de la sociedad civil tanto en la definición del problema como en el diseño e implementación de las respuestas a través de partenariados público-privados.2 Ello es reflejo del enfoque comprehensivo e integral (los denominados whole of goverment approach y whole of society approach), que desde las administraciones públicas y la sociedad civil se han adoptado para articular una respuesta integral frente a un fenómeno complejo y de naturaleza multifacética en el que intervienen factores individuales y grupales de carácter psicológico, socio-económico o político, vinculados a acontecimientos en los ámbitos local, nacional e internacional.3

La creciente llegada de nuevos actores a la escena europea de P/CVE no ha estado, sin embargo, exenta de dificultades. Atraídos por las posibilidades de influir en la agenda pública y en los procesos de toma de decisiones, así como de acceder a nuevas oportunidades de financiación e intervención, profesionales de distintos sectores se han iniciado en P/CVE transfiriendo competencias y conocimientos construidos en otras disciplinas o ámbitos de actuación. A menudo sin experiencia específica en prevención de la radicalización violenta, su desempeño en este campo ha puesto de manifiesto algunas carencias. De entre estas, destaca la falta de una cultura de evaluación que arroje evidencia científica acerca de qué esfuerzos están dando resultados, lo que ha sido resaltado en ambientes políticos y académicos en los últimos años. Tras la movilización yihadista sin precedentes desencadenada en numerosos países de la UE por el estallido del conflicto sirio en 2012, la Radicalisaton Awareness Network (RAN), el organismo dependiente de la Comisión Europea para la prevención y lucha contra la radicalización, constató en 2018 la escasa base de conocimiento existente respecto a la eficacia e impacto de los esfuerzos institucionales e intergubernamentales en materia de P/CVE.4

La evaluación no sólo es una oportunidad de examinar la calidad y efectividad de esas medidas e iniciativas, sino que es también una herramienta de control indispensable para asegurar los principios de transparencia y rendición de cuentas propios de los programas y las políticas públicas en las democracias liberales.5 Contribuye, además, a la mejora de las políticas públicas al informar la toma de decisiones. Con ello y con todo, es ya un lugar común afirmar que la evaluación de políticas y proyectos relacionados con la prevención de la radicalización violenta es todavía un terreno poco desarrollado, en el que los numerosos retos conceptuales, analíticos y operativos han impedido alcanzar niveles de calidad equiparables a los de otros espacios de actuación en los que convergen esfuerzos públicos y privados, como ocurre, por ejemplo, con la ayuda humanitaria.6 Muestra de ello es el estado de la literatura disponible en esta materia: escasa en volumen; limitada en su robustez metodológica y teórica; y sesgada en su enfoque, pues el grueso de lo publicado está centrado en el análisis de intervenciones de prevención terciaria (dirigidas a lograr el desenganche, des-radicalización y rehabilitación de terroristas), o de proyectos desarrollados en países externos a la UE, donde las organizaciones terroristas ejercen un control territorial efectivo o cuentan con niveles significativo de apoyo social en sus comunidades de referencia.7

Sin embargo, esta producción científica puede resultar de utilidad limitada para actores que se inician en el ámbito P/CVE, pues se enfrentan a retos muy distintos. Este Documento de Trabajo aboga, pues, por el desarrollo de una cultura de evaluación entre estos agentes basada en las lecciones aprendidas de esfuerzos similares. Para desarrollar mecanismos de institucionalización del aprendizaje en evaluación, este informe expone la experiencia y lecciones aprendidas en esa materia desarrollada en el marco del proyecto europeo H2020 MINDb4ACT (2017-2020),8 identificando retos del diseño, implementación y análisis de la evaluación en proyectos dirigidos a la prevención de la radicalización violenta. Su utilidad no se limita a intervenciones dirigidas a una ideología específica, pues en el marco del MINDb4ACT se han trabajado distintos extremismos, si bien ha predominado el salafismo yihadista. El documento propone buenas prácticas y recomendaciones dirigidas tanto a decisores políticos como a otros actores y partes interesadas para la inclusión de una estrategia de evaluación realista en sus intervenciones.

(2) Intervenciones a pequeña escala para la prevención de la radicalización violenta

Orientado a la mejora de las capacidades del sistema europeo de P/CVE, el proyecto MINDb4ACT adoptó un enfoque eminentemente práctico a través del desarrollo de 15 intervenciones a pequeña escala en cuatro dominios (centros educativos, instituciones penitenciarias, entornos urbanos e Internet) de nueve países europeos representativos de los ejes geográficos de la Unión.9 Financiado por la Comisión Europea a través de su programa Horizonte 2020, MINDb4ACT es, en buena medida, reflejo y consecuencia de la configuración del ecosistema europeo de P/CVE. El consorcio que impulsó el proyecto es representativo del llamado enfoque multiagencia, en el que conviven decisores políticos, sector privado, tercer sector, academia (universidades y think tanks), y fuerzas y cuerpos de seguridad. Aunque con conocimiento y experiencia en materia de P/CVE, la mayoría de los socios contaba con una trayectoria incipiente en intervención y evaluación de proyectos diseñados específicamente en este ámbito.

Una serie de elementos armonizan las 15 intervenciones piloto desarrolladas en el curso del proyecto MINDb4ACT:

- Metodología: los diseños de las intervenciones piloto responden a las necesidades de distintos colectivos profesionales que trabajan en contextos donde los procesos de radicalización violenta tienden a ocurrir o a ser detectados (los ya mencionados ámbitos de la educación, las prisiones, las ciudades e Internet). La metodología empleada para llevar a cabo la evaluación de necesidades es conocida como Living Lab, un proceso de inteligencia colectiva que permite trabajar de forma horizontal, sin jerarquías, a profesionales y otros actores relevantes en dos propósitos: en primer lugar, la identificación de carencias y/o necesidades existentes en el ámbito P/CVE; y, en segundo lugar, el co-diseño de la solución a esas necesidades o carencias, es decir, el resultado de la intervención en sí misma. En todos los casos, las intervenciones fueron desarrolladas a pequeña escala, es decir, consistieron en proyectos de corta duración, en los que participó un reducido equipo de personas dedicadas a su diseño, implementación y evaluación (a menudo, no más de dos profesionales), disponiendo de presupuestos limitados y actuando sobre espacios de intervención muy acotados.

- Objetivos: las intervenciones buscan generar impactos sobre la actividad profesional por medio del desarrollo y transferencia de conocimientos, metodologías y técnicas. No se trata, pues, de proyectos dirigidos a comunidades o individuos vulnerables a experimentar procesos de radicalización violenta, sino a colectivos profesionales que afrontan los retos de la radicalización violenta en su ámbito de trabajo (actores de primera línea, funcionarios, educadores, etc.).10 Las necesidades detectadas han dado lugar a intervenciones dirigidas al desarrollo de competencias profesionales (programas formativos especializados y de alto nivel) o a herramientas de acceso a información, gestión de casos o comunicación interprofesional.

- Limitaciones: debido a los marcos que impone el propio programa financiador, las intervenciones están construidas sobre horizontes temporales cortos (aproximadamente de un año de duración), con presupuestos ajustados, aunque con la perspectiva de ampliar el número de beneficiarios directos en posteriores reediciones de los proyectos. Por tanto, son experiencias piloto de las que se espera extraer lecciones que permitan su mejora y sostenibilidad.

- Modelo de evaluación: en la práctica totalidad de los casos, los proyectos han sido evaluados por los propios equipos encargados del diseño y desarrollo de la iniciativa. Esta evaluación interna es una práctica extendida en intervenciones piloto de bajo presupuesto, lo que permite adoptar un enfoque de “ensayo y error” para refinar el proyecto antes de su replicación. Aunque las evaluaciones llevadas a cabo por evaluadores externos garantizan objetividad y conocimiento técnico, a menudo son costosas y requieren de competencias que no son fáciles de encontrar en muchos contextos. La falta de familiaridad con el proyecto y con los agentes relevantes por parte de los evaluadores externos suponen también una limitación importante en un ámbito como el de P/CVE, en el que la confianza entre actores facilita el acceso a la información. En este sentido, apostar por una evaluación interna de las intervenciones no es sólo el enfoque más pragmático en el caso de proyectos con recursos limitados (económicos y/o temporales), sino que también favorece la profesionalización de los profesionales/evaluadores. Por otro lado, las dudas acerca de la fiabilidad de los resultados de evaluaciones internas pueden verse contrarrestadas con un diseño estructurado y metodológicamente solvente, y con una orientación basada en criterios de evaluación estandarizados, como el marco establecido por la OCDE y los DAC Standards.12

¿Qué retos han afrontado los agentes de implementación en el diseño de la evaluación de sus intervenciones? ¿Cuáles han sido las limitaciones y soluciones durante la fase de implementación? ¿De qué modo han analizado los resultados? Las siguientes páginas capturan lecciones específicas extraídas del desarrollo de un marco de evaluación en proyectos P/CVE dentro de MINDb4ACT.

(3) Una evaluación en tres fases: diseño, implementación y análisis

(3.1) El diseño

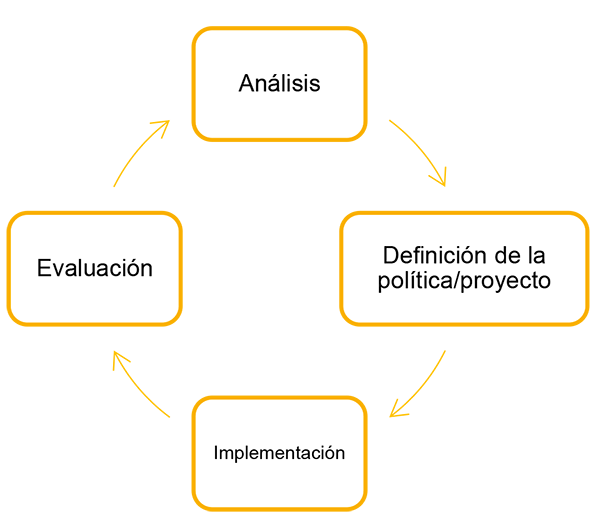

En el marco de un ciclo de políticas públicas, la evaluación siempre figura como la última de las fases del proceso (véase la Figura 1). La práctica demuestra, sin embargo, que el diseño de una evaluación debe ser contemplado desde el mismo principio de la intervención para prever, entre otros aspectos, los resultados que quieren medirse, el tipo de datos que se necesitan y el momento en que se deben recoger. Un error común entre agentes de implementación con limitada experiencia en intervención en materia de P/CVE es no incorporar el diseño de la evaluación como un elemento integral de la planificación del proyecto, lo que puede limitar su utilidad, en la medida en que será difícil abordar a posteriori los principales interrogantes que suscite la intervención.

La formulación de una evaluación se inicia con la definición de sus objetivos. Cuando los proyectos tienen un ciclo de vida corto (se diseñan e implementan en el espacio de un año, aproximadamente), es muy probable que la evaluación se enfoque fundamentalmente a estudiar el producto (output evaluation) o su resultado a corto plazo (outcome evaluation) y, en menor medida, a analizar los efectos en el medio término (impact evaluation). La valoración sobre la calidad y relevancia de los contenidos de un curso sobre prevención de la radicalización violenta constituye una muestra de lo primero; la comprobación de la medida en que los asistentes han mejorado su conocimientos y aptitudes en esa área es ejemplo de lo segundo; finalmente, la revisión del grado en que esas competencias se han transferido a la práctica profesional es reflejo de lo tercero.

Uno de los primeros retos que afrontan los implementadores es hacer partícipes del diseño de la evaluación a todos los actores directa o indirectamente relacionados con la intervención, particularmente aquellos que se convertirán en sus usuarios finales. Una evaluación debe ser un proceso inclusivo y transparente, que recoja las inquietudes de quienes intervienen de un modo u otro en la puesta en marcha de un proyecto, pueden asegurar su sostenibilidad, o van a experimentar o estudiar sus efectos en el tiempo. Ello facilitará la posterior recogida de datos y asegurará la toma en consideración de los resultados que se obtengan. Las experiencias de evaluación desarrolladas en MINDb4ACT demuestran que a menudo las necesidades difieren entre los agentes de implementación, los decisores políticos, los investigadores académicos o las comunidades locales: mientras que unos están interesados principalmente en conocer los resultados del proyecto, otros también esperan saber si los recursos invertidos se han utilizado de forma óptima y responsable. Conviene hallar un equilibrio entre los intereses de los actores consensuando las preguntas que articularán el trabajo de evaluación, y que pueden estructurarse siguiendo criterios estandarizados como los de la DAC de la OCDE (relevancia, coherencia, eficiencia, eficacia, impacto y sostenibilidad). Factores como los medios económicos, temporales y humanos deben ser también tenidos en cuenta.

Alcanzar una visión compartida entre profesionales y actores relevantes es igualmente importante al examinar la Teoría del Cambio de la intervención, en la que se esquematiza la cadena de resultados que conduce desde los insumos y actividades del proyecto hasta sus efectos.13 Formular de manera colectiva las hipótesis sobre cómo se produce el cambio y el modo en que la intervención puede desencadenarlo permitirá a todos los actores ser realistas en relación con los efectos que se persiguen y llegar a un criterio común acerca de lo que se entiende por éxito (o fracaso) del proyecto.

La experiencia indica que las expectativas de los agentes de implementación en el ámbito de P/CVE son altas en relación con el fortalecimiento de las capacidades profesionales y sus posibilidades de medición. Algunos de los cambios esperados constituyen modificaciones cognitivas (como, por ejemplo, aumentos en el conocimiento, una mejora de la confianza profesional o transformaciones actitudinales) que son difíciles de medir de un modo riguroso. Supervisar cambios de índole conductual (por ejemplo, la aplicación de determinadas prácticas o la intensificación de la colaboración interprofesional) entraña también ciertas dificultades, particularmente en contextos laborales donde las complejas dinámicas de trabajo pueden ralentizar la incorporación de nuevas culturas de actuación (como en centros penitenciarios o en la atención social). Ser realista obliga a definir criterios de evaluación que contemplen las condiciones y características del contexto de intervención, y a descartar objetivos difícilmente alcanzables, como el de pretender establecer relaciones causales entre el proyecto y un determinado resultado cuando no es posible definir grupos de control o aislar otros factores que han podido contribuir, facilitar o afectar el resultado. Ser realista comporta también elegir apropiadamente los indicadores de la evaluación, tanto en términos cuantitativos (algunos evaluadores suelen inclinarse por definir un número muy elevado) como cualitativos (existe también la tendencia a definir indicadores que no pueden medirse utilizando los datos disponibles).

A menudo, el interés está en conocer los efectos sobre la práctica profesional, o incluso a nivel institucional, pero para medir el impacto en el largo plazo es necesario que haya transcurrido tiempo suficiente tras la finalización del proyecto, y esta es una opción poco viable para programas construidos sobre horizontes temporales cortos. No obstante, no se debe renunciar a la posibilidad de evaluar esos efectos cuando se produzca la finalización del proyecto. En cualquier caso, una alternativa viable dentro del calendario del proyecto consiste en evaluar la medida en que la intervención ha contribuido a avanzar en una trayectoria definida hacia impactos en el largo plazo, es decir, comprobar la distancia que se ha recorrido entre el punto de partida y el objetivo final. Otros interrogantes relevantes que puede responder la evaluación tienen que ver con la relevancia y sostenibilidad de una intervención (por ejemplo, si sus participantes actúan como agentes multiplicadores transfiriendo conocimientos y técnicas a otros profesionales de sus propias organizaciones o si los conocimientos adquiridos son retenidos en el tiempo).

Conviene también ser consciente de los factores externos al proyecto que condicionan la capacidad de evaluar los indicadores definidos. De entre los más importantes, cabe considerar que la incidencia de la radicalización violenta en Europa Occidental es limitada cuando se compara con la de terceros países, incluso en contextos en los que aparentemente ocurre con mayor frecuencia. Algunos de los proyectos llevados a cabo en MINDb4ACT en prisiones y ámbitos urbanos con profesionales que trabajan con colectivos susceptibles de experimentar procesos de radicalización muestran que las posibilidades reales de medir el impacto de una intervención son moderadas en tanto en cuanto el número de casos sobre los que los profesionales podrán aplicar competencias, herramientas o protocolos suele ser reducido. De igual modo, examinar los resultados de la intervención en clave de género puede resultar complejo si no existe un relativo equilibrio entre hombres y mujeres entre los participantes del proyecto (en algunos sectores, particularmente en el ámbito de la seguridad, la presencia de mujeres es todavía significativamente inferior a la de hombres)14 o entre la población diana de la intervención (como es bien sabido, existe mayor incidencia de radicalización violenta entre hombres que entre mujeres). También es posible que criterios éticos, deontológicos y de protección de datos impidan acceder a la información necesaria para evaluar los criterios seleccionados.

(3.2) La implementación

La elección y configuración de los instrumentos de recogida de datos constituye otro de los retos para agentes de implementación con limitada experiencia de intervención en el ámbito P/CVE. Una buena estrategia para la selección de las herramientas de recopilación de datos debe basarse en los objetivos y preguntas de la evaluación, y debe tener como principio rector la triangulación de la información, es decir, la combinación de distintos instrumentos de recogida de datos (preferiblemente conjugando metodologías cuantitativas y cualitativas) y de diferentes fuentes de información. En la experiencia de MINDb4ACT, los profesionales que buscan capturar cambios cognitivos o conductuales en colectivos profesionales (conocimiento, actitudes, prácticas o relaciones) utilizaron pre tests y post tests, encuestas de valoración y sesiones de evaluación, así como, en menor medida, revisión de documentos y observación directa.

Aun cuando la elección de los instrumentos resulte acertada, limitaciones prácticas y problemas analíticos pueden acabar afectando la validez y utilidad de los resultados. Una buena planificación de los tiempos resulta fundamental para que la evaluación dé respuesta a los interrogantes formulados. La experiencia de los profesionales en el contexto de MINDb4ACT demuestra que medir la eficacia e impacto de un proyecto requiere generalmente de una toma de datos de referencia, previa al inicio de la intervención, pero también transcurrido un tiempo (a menudo, superior a los tres meses) tras la finalización de esta; de lo contrario, los cambios producidos por el proyecto no podrán ser monitorizados y analizados de modo objetivo. Asimismo, varios profesionales indicaron que el uso de instrumentos de recogida de datos online (fundamentalmente encuestas virtuales) tiende a generar ratios de respuesta más bajos e información menos exhaustiva que la obtenida con instrumentos similares utilizados en metodologías offline, lo que sin duda puede repercutir negativamente en la relevancia de los datos.

Otra de las dificultades operativas a que se enfrentan los profesionales estriba en lograr acceso a las fuentes de información. La mayoría de las evaluaciones sobre proyectos dirigidos a colectivos profesionales adoptan un enfoque centrado en el participante. Generar un clima de confianza y sensibilizar a los beneficiarios de la intervención sobre la utilidad de la evaluación será crucial para lograr su compromiso y despejar cualquier circunstancia que pudiera disuadirles de implicarse en ella. En un ámbito tan sensible como el de la prevención de la radicalización violenta, los profesionales pueden mostrarse reticentes a compartir opiniones o información basada en situaciones reales, pueden tener dudas éticas o, sencillamente, pueden estar sobrecargados por el trabajo ordinario o no considerar la evaluación como una prioridad. Poner en valor la repercusión positiva de la evaluación en la mejora de políticas públicas e incluso en la labor profesional de los encuestados es fundamental. La valoración de los actores relevantes del proyecto es también valorada como útil por algunos profesionales, razón por la que lograr su apropiación del proceso debe ser tenido como objetivo prioritario desde el principio. Alternativamente, puede aumentarse el conjunto de datos recopilados implicando en la evaluación a actores no involucrados en el proyecto a través de metodologías como paneles de expertos o informantes clave (key informants).15

Otra limitación analítica que puede emerger a lo largo del procedimiento de evaluación deriva de una concepción estrecha de la información que puede ser puesta a disposición de los evaluadores. En el diseño de los instrumentos de recogida de datos conviene tener en cuenta que el objetivo ideal de una evaluación no es sólo valorar si un proyecto ha funcionado o no en términos generales. Preferiblemente, debe poder arrojar luz acerca de qué elementos específicos del proyecto han funcionado y cuáles no, para qué beneficiarios, de qué modo, bajo qué circunstancias, en qué medida y por qué. Contemplar algunos de esos interrogantes y establecer variables que permitan segmentar las respuestas (por ejemplo, según género, ámbito profesional, experiencia en P/CVE, etcétera) permitirá un análisis pormenorizado y realista.

Finalmente, otra de las principales preocupaciones de los evaluadores durante la implementación del proceso es la gestión de los criterios éticos. Para que el procedimiento resulte ajustado a la normativa en esa materia, los participantes de la evaluación deben ser conocedores de los objetivos y consecuencias de su colaboración y deben tener garantizado el anonimato y la confidencialidad de sus respuestas, así como su derecho a retirarse de la actividad en cualquier momento, entre otros aspectos. Proporcionar un consentimiento informado con información relevante y exhaustiva es ya una práctica extendida. Con todo, el principal reto mencionado por los agentes de evaluación de MINDb4ACT es el de asegurar en el procedimiento de reclutamiento un equilibrio entre la protección de datos y la voluntariedad de la participación. Podría parecer razonable que la mejor forma de alcanzar ese equilibrio es delegar el reclutamiento de los participantes en la evaluación en los propios actores relevantes; sin embargo, es posible que ello afecte a la capacidad de los sujetos para negarse libremente a participar en la evaluación cuando la propuesta llega de sus superiores jerárquicos.

(3.3) El análisis

La identificación y control de los sesgos constituye una de las grandes dificultades que afectan al análisis de los resultados. De entrada, los agentes de implementación pueden sentirse tentados de ocultar resultados negativos y enfatizar los positivos por temor a los costes reputacionales de una intervención que no logra los cambios esperados o por el riesgo a perder la financiación para dar continuidad al proyecto. Una definición realista de los efectos que se persiguen y de los resultados que se esperan obtener de la evaluación puede rebajar la presión sobre los profesionales que evalúan sus propias iniciativas. La falta de una cultura de evaluación entre actores inexpertos puede también ocasionar una deficiente comprensión sobre la utilidad de una evaluación, que no sólo debe servir para identificar buenas prácticas, sino que también debe conducir al establecimiento de los cambios necesarios en la intervención a fin de optimizar su desarrollo. Resultados negativos no necesariamente revelan el fracaso de una intervención, sino la necesidad de introducir mejoras en su diseño e implementación.

Lecciones aprendidas del proyecto MINDb4ACT también demuestran que los agentes de implementación con menor experiencia suelen ignorar en el análisis los efectos indirectos e indeseados producidos por sus proyectos. A menudo, los efectos indeseados que más preocupan a los profesionales en el ámbito de P/CVE son los denominados efectos iatrogénicos, como la estigmatización de comunidades y colectivos.16 Sin embargo, otra serie de resultados no deseados pueden quedar fuera del radar de los agentes implementadores, como aquellos que afectan al contexto organizativo e institucional en el que se desarrolla la intervención. Es posible que esos resultados no pasen desapercibidos a otros actores que intervengan en el análisis de los datos recogidos, por lo que potenciar su implicación es altamente aconsejable.

La transparencia del proceso y la triangulación de los datos han sido identificados como pasos clave para asegurar un análisis consistente de la intervención. Admitir las limitaciones metodológicas y analíticas de la evaluación y compartir los datos en bruto con actores relevantes favorece la rendición de cuentas y la credibilidad del proceso. De igual modo, contrastar los datos cuantitativos y cualitativos de la evaluación arrojará una imagen realista del modo en que la intervención ha contribuido a los cambios esperados. Las opiniones y valoraciones de los beneficiarios deben ser confrontadas con las de otras fuentes de información para conocer el alcance real de los resultados.

La identificación de sesgos en la respuesta de los beneficiarios de la intervención resulta también crucial para asegurar la fiabilidad del análisis. Algunos agentes de implementación en MINDb4ACT indicaron que las opiniones de los beneficiarios tendieron a ser menos positivas que la de otros participantes en la evaluación. En ocasiones, esto se debió a que los participantes en el proyecto son exigentes en sus expectativas acerca del modo en que la intervención puede resolver sus necesidades. Su valoración debe ponderarse con el hecho de que la prevención de la radicalización violenta es todavía un ámbito de investigación e intervención en proceso de desarrollo. Las respuestas a los retos que entraña en cualquier ámbito de actividad (ya sea en centros penitenciarios o en ciudades, escuelas o el entorno virtual, entre otros posibles) están todavía basadas prioritariamente en el “ensayo y error” y en un enfoque personalizado y altamente contextual, lo que limita la disponibilidad de recursos formativos, protocolos o herramientas avanzados. En consecuencia, algunas de las necesidades identificadas por los profesionales pueden ser atendidas de un modo limitado y quizá no del todo satisfactorio.

Asimismo, una inapropiada elección de los beneficiarios de la intervención también puede sesgar los resultados. La evaluación de una herramienta por profesionales que carecen de las competencias para hacer uso de ella (por ejemplo, conocimiento de una lengua o acceso a un público potencial sobre el que aplicarla) previsiblemente arrojará una valoración tendenciosa que no ayuda a una comprensión del modo en que el instrumento contribuye a mejorar la práctica profesional. De igual modo, en proyectos que adoptan el enfoque multiagencia y tienen como grupo diana a un conjunto heterogéneo de profesionales con necesidades profesionales y expectativas diferentes, es esperable que el rendimiento de los distintos colectivos será desigual durante el proyecto y su percepción de los resultados también diferirá.

La necesidad de un enfoque pragmático y realista vuelve a ponerse de manifiesto en la elaboración de recomendaciones a partir de los resultados de la evaluación. El reto está en evitar formular sugerencias que sean difíciles de llevar a la práctica o que no se desprendan de forma lógica de los resultados del proyecto. Algunos profesionales pueden tener la tentación de proponer la replicación y escalamiento de su intervención en otros contextos o lugares cuando los resultados de la evaluación no demuestran que la necesidad que inspiró el proyecto sea generalizada en un sector o ámbito de trabajo. Los evaluadores deben abstraerse de las prioridades de la agenda política y las preocupaciones de la opinión pública en relación con el terrorismo y la radicalización violenta, y apostar por la sostenibilidad de sus propuestas sólo cuando su pertinencia resulte clara. Una buena estrategia para formular recomendaciones realistas consiste en seguir los criterios SMART (Specific, Measurable, Achievable, Relevant and Time bound). Asimismo, la práctica demuestra que los actores relevantes tienen un mejor conocimiento del contexto en el que se interviene y que su diagnóstico de la situación puede ser especialmente útil para la definición de recomendaciones accionables.

Fomentar una cultura de evaluación en el ámbito de P/CVE requiere también que los resultados de las intervenciones sean diseminados en abierto para que todos los actores que forman parte de la comunidad puedan conocer las lecciones aprendidas y evitar los errores comunes durante la práctica. Favorecer el intercambio de experiencias y conocimientos y promover buenas prácticas es clave para una mejora de las competencias en evaluación. Evaluadores inexpertos pueden sentirse inseguros compartiendo sus limitados resultados, pero esa es la única vía para ampliar la base de conocimiento en esta materia. A ello contribuirá desarrollar formatos de diseminación de resultados más allá del informe del proyecto (por ejemplo, a través de participación en workshops, seminarios científicos, publicación de artículos o posts).

Conclusiones

La experiencia y lecciones aprendidas a partir de la evaluación de 15 intervenciones piloto desarrolladas en nueve países europeos para prevenir la radicalización violenta, dentro del marco del proyecto H2020 MINDb4ACT, informan una serie de recomendaciones dirigidas a generar una cultura de evaluación en el ámbito P/CVE:

- Inclusividad: tanto agentes de implementación como actores relevantes deben entender la lógica de un proceso inclusivo. Para los primeros, una evaluación participativa facilitará la recogida de datos y asegurará que los resultados sean tomados en consideración por los actores responsables de la sostenibilidad de la intervención. Para los segundos, la apropiación del proceso asegurará su utilidad, en la medida en que sólo así dará respuesta a sus intereses y necesidades y reflejará soluciones viables, que apunten a metas alcanzables de un modo que optimice los medios disponibles. No lograr implicar a los actores relevantes en los trabajos de evaluación desde el principio del proyecto, o perder su complicidad a lo largo del proceso, puede impedir que la evaluación llegue a informar la toma de decisiones y, por tanto, contribuir verdaderamente a una política basada en evidencia.

- Pragmatismo: durante la evaluación, es fundamental gestionar las expectativas de todos los actores implicados, tanto en términos de la ambición del proceso, como en relación con los objetivos establecidos y los resultados esperados. Ello permitirá un marco de trabajo riguroso y fiable, en el que los esfuerzos no se dirijan estérilmente a probar resultados que puedan ser cuestionados externamente. El realismo debe primar en el diseño de los criterios de evaluación, pero también en la implementación de los trabajos, promoviendo así que se recojan datos pormenorizados que permitan una mejor comprensión del modo en que un proyecto contribuye a un cambio determinado. Finalmente, el pragmatismo también debe imponerse en el análisis, pues las recomendaciones que deriven de la evaluación deben ser accionables para introducir verdaderas mejoras en P/CVE.

- Transparencia y ética: optar por un modelo de evaluación interna es una decisión pragmática en proyectos de corta duración y limitado presupuesto. Permite optimizar recursos a la vez que fortalece las competencias de los agentes de implementación. Sin embargo, su utilidad puede verse afectada por la cautela con la que suelen interpretarse sus resultados. Asegurar un proceso transparente con actores relevantes y decisores políticos permitirá contrarrestar esas dudas. Para ello, es importante que los evaluadores mantengan una comunicación regular y fluida con el resto de actores involucrados o interesados en la intervención: compartir el diseño metodológico de la evaluación y de los instrumentos de recogida de datos, para posibilitar su validación; informar sobre la marcha de la implementación del proceso; y ofrecer los datos brutos recopilados así como cualquier otro elemento utilizado en el análisis (relación de documentos analizados, personas entrevistadas, etc.), para que puedan ser estudiados independientemente. La transparencia debe imponerse también en la relación con los participantes de la evaluación, cumpliendo así con los estándares éticos. Los sujetos evaluados deben ser informados sobre los objetivos y las consecuencias de su implicación en la evaluación. Ser transparentes con ellos también favorecerá un mayor grado de implicación en el proceso. Finalmente, la transparencia con el resto del ecosistema P/CVE debe materializarse en la publicación y diseminación de los resultados de la evaluación, lo que permitirá un intercambio de buenas prácticas y de hallazgos empíricos.

- Utilidad/finalidad: los objetivos de la evaluación deben resultar claros tanto para los evaluadores como para los actores relevantes, de manera que estos sean quienes guíen el trabajo a desarrollar. Debe considerarse que una evaluación puede servir a distintos propósitos: mientras que los profesionales tendrán interés en conocer los resultados de una intervención, los decisores políticos pueden utilizar los resultados para adoptar decisiones en relación con la distribución de recursos o el aumento de la inversión. Además, la evaluación no siempre tiene como única finalidad la de comprobar si una determinada intervención funciona o no; también arroja luz acerca de qué elementos han funcionado y cuáles no, para qué beneficiarios, de qué modo, bajo qué circunstancias, en qué medida y por qué.

- Perspectiva de género: la incorporación de una perspectiva de género en la evaluación de proyectos P/CVE responde a la necesidad de entender de un modo comprehensivo los efectos diferenciales de la intervención sobre sus beneficiarios y, en última instancia, a nivel institucional y organizativo. Una recogida de datos segmentada en clave de género debe ser considerada en el propio diseño de la evaluación, ejecutada durante la implementación y reflejada en el análisis. Idealmente, deben también plantearse recomendaciones dirigidas a introducir cambios que mejoren los impactos de la intervención en esta dimensión.

Álvaro Vicente

Investigador del Programa sobre Radicalización Violenta y Terrorismo Global, Real Instituto Elcano, y miembro del Proyecto H2020 MINDb4ACT | @alvaro_vicentep

Carola García-Calvo

Investigadora principal del Programa sobre Radicalización Violenta y Terrorismo Global, Real Instituto Elcano, y miembro del Proyecto H2020 MINDb4ACT | @carolagc13

1 Council of the European Union (2005), “The European Union counter-terrorism strategy”, Bruselas.

2 Global Counterterrorism Forum (2013), Ankara Memorandum on Good Practices for a Multi-Sectoral Approach to Countering Violent Extremism.

3 Mohammed Hafez y Creighton Mullins (2015), “The radicalization puzzle: a theoretical synthesis of empirical approaches to homegrown extremism”, Studies in Conflict and Terrorism, vol. 38, nº 11, pp. 958-975.

4 RAN (2018), “Guideline evaluation Of Pcve programmes and interventions”, Ex post paper.

5 Agencia Estatal de Evaluación de las Políticas Públicas y la Calidad de los Servicios (AEVAL) (2015), “Guía práctica para el diseño y evaluación de políticas públicas”, Ministerio de Hacienda y Administraciones Públicas, Madrid, pp. 24-25 y 92.

6 Peter Romaniuk (2015), “Does CVe work? Lessons learned from the global effort to counter violent extremism”, Global Center on Cooperative security.

7 A.R. Feddes y M.A. Galluci (2019), “Literature review on methodology used in evaluating effects of preventive and de-radicalisation interventions”, Journal for Deradicalization, nº 19, pp. 1-27, ; National Consortium for the Study of Terrorism and Responses to Terrorism (2016), “Surveying CVE metrics in prevention, disengagement and deradicalization programs: report to the US Department of Homeland Security”, University of Maryland, ; Eric Rosand, Emily Winterbotham, Michael Jones y Franziska Praxl-Tabuchi (2018), “A roadmap to progress: the state of the global P/CVE agenda”, The Prevention Project and Royal United Services Institute. Existen notables excepciones, como las iniciativas impulsadas por la RAN EU o el trabajo desarrollado en la evaluación de Channel UK, pero se trata de acciones restringidas a unos pocos contextos (virtual-counter-narrative campaigns y educativo).

8 El proyecto MINDb4ACT, “Mapping, identifying and developing skills and opportunities in operating environments to co-create innovative, ethical and effective actions to tackle radicalisation leading to violent extremism”, liderado por el Real Instituto Elcano, ha sido financiado por la Comisión Europea a través de su programa Horizonte 2020, en virtud del Grant Agreement No 74054.

9 Puede encontrarse más información del proyecto.

10 L. Lindekilde (2012), “Value for money? Problems of impact assessment of counter-radicalisation policies on end target groups: the case of Denmark”, Eur J Crim Policy Res, nº 18, pp. 385-402.

11 Department for Communities and Local Government (2012), Evaluating Local PREVENT Projects and Programmes. Guidelines for Local Authorities and their Partners and Resource Pack for Local Authorities and their Partners, p. 5; World Health Organization (2013), WHO Evaluation Practice Handbook, p. 44; EFUS (2017), Prevention of Violent Radicalisation – Methodological Guide for the Development of a Local Strategy, p. 67; RAN (2019), “Evaluating disengagement, deradicalisation and resocialisation efforts”, Ex Post Paper.

12 OCDE (2020), OECD/DAC: Criteria for Evaluating Development Assistance.

13 Joanna Hofman y Alex Sutherland (2018), Evaluating Interventions that Prevent or Counter Violent Extremism. A Practical Guide, RAND Corporation.

14 Por poner sólo un ejemplo, según datos de Eurostat las mujeres representan hoy el 17% del total de los miembros de las Law Enforcement Agencies en la EU. Véase “Eurostat Statistics, Police officers, EU-28, 2009-2017”.

15 Hofman y Sutherland (2018), op. cit.

16 Lasse Lindekilde (2011), “Neo-liberal governing of “radicals”: Danish radicalization prevention policies and potential iatrogenic effects”, International Journal of Conflict and Violence, vol. 6, nº 1, pp. 109