El estudio PISA, esa evaluación de los muchachos de 15 años que la OCDE hace cada tres años, ha tenido un éxito arrollador: ya participan en ella más de 60 países, el 90% de la humanidad, y sus resultados tienen un amplio eco mediático y político, que también va en aumento. Tanto, que los resultados de 2012 se han dado a conocer en dos veces: en diciembre de 2013 los resultados de Lectura, Matemáticas y Ciencias, y en Abril de 2014 los resultados de una prueba distinta, la resolución de problemas. En Diciembre, los resultados fueron los mismos que en ediciones anteriores, lo que sólo sirvió en España para renovar las quejas de que no mejorábamos. En abril, los resultados han sido peores que en diciembre, lo que ha dado ocasión para un nuevo despliegue de críticas a las escuelas y a los gobiernos. Cada uno ha denunciado a su culpable favorito (LOGSE, TV basura, recortes, autoritarismo, laxitud) y ha propuesto su reforma predilecta. Algunos economistas han vuelto a encontrar en la escuela la causa de la crisis económica y el MEC ha vuelto a destacar: ha prometido que con la nueva ley de Educación, la LOMCE, el memorismo culpable del desastre será por fin desplazado por los métodos activos y creativos que los progresistas llevan ya siglos intentando implantar. Conviene advertir, por lo demás, que esto ocurre exactamente igual que en España en todos los todos los países donde PISA defrauda.

Ante tanto revuelo, resulta alarmante que leyendo el informe de la OCDE (2014) se pueda llegar a la conclusión de que no estamos ante un problema real, sino más bien ante una creación de PISA.

En PISA 2003 se aplicó ya una prueba de Resolución de Problemas, presentada como una prueba interdisciplinar en que se aplicaban a la vida ‘real’ las competencias en Lectura, Matemáticas y Ciencias. Los resultados respondieron a esta concepción. Las correlaciones de Resolución de Problemas con las otras pruebas fueron muy altas: 0,80 con Ciencias, 0,82 con Lectura, 0,89 con Matemáticas. Ciertos países puntuaban en Resolución de Problemas más alto y otros más bajo que en Matemáticas, pero eran diferencias menores que las de Lectura y Ciencias (OECD, 2004). A tenor de estos resultados, la prueba de problemas (PS, Problem Solving) pasó sin pena ni gloria como una subprueba de Matemáticas.

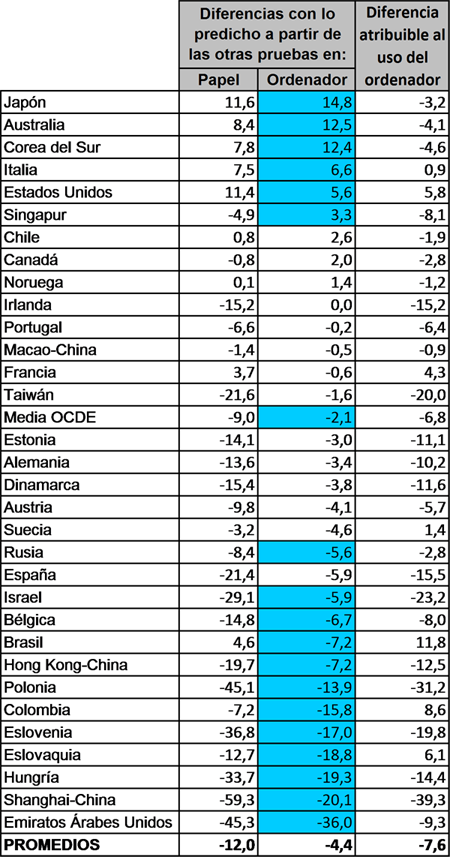

En PISA 2012, las diferencias entre la prueba de Resolución de Problemas y el resto de pruebas PISA son mayores que en 2003. Las correlaciones son algo menores: 0,81 con Matemáticas, 0,75 con Lectura y 0,78 con Ciencias. Además, PISA calcula las puntuaciones que se esperarían en la prueba PS a partir de las puntuaciones en las otras pruebas y encuentra que, como puede verse en la tabla 1, pocos países puntúan por encima y muchos bastante por debajo, entre ellos España. La OCDE basa en esto s un vuelco en la interpretación: la resolución de problemas es la capacidad realmente importante para el éxito en la vida. Pero las escuelas se quedan en las materias tradicionales.

¿Existe realmente este déficit en la Resolución de Problemas? ¿Cómo es que no se detectó en 2003?. El propio informe de la OCDE nos da la respuesta: buena parte del ‘deficit’ se debe a a que la prueba de 2012 se ha administrado mediante ordenadores. ¿Cómo se puede saber esto?. Muy sencillo: en algunos países, también parte de las pruebas de Matemáticas y Lectura se han aplicado con ordenador, con resultados peores. Las puntuaciones esperadas en Resolución de Problemas a partir de Matemáticas realizadas con ordenador difieren mucho menos de las reales que las predichas desde Matemáticas en papel, como puede verse en la tabla 1.

En España, el efecto del ordenador es de 15 puntos, dejando una diferencia de seis puntos que no es estadísticamente significativa (INEE, 2014, p.107). La inferioridad de los alumnos españoles no está en la resolución de problemas, sino en el instrumento con que se hace la prueba. Más detalladamente, en 2003 los alumnos españoles de 15 años obtuvieron 485 puntos en PISA matemáticas sobre papel, y 482 en resolución de problemas sobre papel; en 2012 los alumnos españoles de 15 años obtuvieron 484 puntos en Matemáticas sobre papel, 475 puntos en Matemáticas con ordenador y 477 puntos en resolución de problemas con ordenador. (Más detalles en Carabaña2014).

La explicación es sencilla y parsimoniosa. Si es que hay un problema, es el del manejo de los ordenadores. Y sin embargo la OCDE desprecia esta explicación y continúa su informe especulando sobre el déficit en la resolución de problemas recuerda a ciertos periodistas que no dejan que la realidad les estropee un buen reportaje, o a ciertos científicos que no permiten a los hechos inutilizar sus teorías. ¿Por qué habría la OCDE de comportarse de este modo?. Según los psicólogos especializados en resolución de problemas, fallos como estos suelen proceder de causas no cognitivas.

Referencias

Carabaña, Julio (2014). “No problemas reales, sino dispositivos electónicos desconocidos”. Avances en supervisión educativa, 20: 1-15.

INEE, PISA 2012. Resolución de problemas en la vida real. Informe preliminar, Ministerio de Educación, Cultura y Deporte, Madrid.

OECD (2004), Problem Solving for Tomorrow’s World. First Measures of Cross-Curricular Competencies from PISA 2003, OECD, Paris

OECD (2014), PISA 2012 Results: Creative Problem Solving: Students’ Skills in Tackling Real-Life Problems (Volume V), PISA, OECD