En enero de 2020, Microsoft anunció la creación de una delegación permanente ante las Naciones Unidas en Nueva York con el fin de hacer avanzar los Objetivos de Desarrollo Sostenible a través de la tecnología y su impacto en la seguridad, desarrollo, medio ambiente y los asuntos humanitarios. Al mismo tiempo, esta misma Big Tech designaba a un diplomático (danés) por primera vez como nuevo vicepresidente para Asuntos Públicos Europeos en Bruselas. Mientras, IBM tiene un laboratorio novel sobre política tecnológica cuyos miembros ya participan en las reuniones políticas más importantes de varias ciudades.

Es cierto que uno de los pilares fundamentales para el éxito de las grandes empresas tecnológicas siempre ha sido labrar un potente grupo de influencia entre los decisores políticos y regulativos. Sin embargo, lo que ha cambiado en los últimos años es la naturaleza de sus objetivos y la forma en que lo llevan a cabo: de ser grupos de interés externos que aspiraban a maximizar sus metas corporativas, ahora empiezan a convertirse en decisores reales del “policy-making”. Han dejado de ser quienes llamaban a la puerta, para ser una de las voces (relevantes) dentro de los despachos. La idea de ellos como el “Otro” antropológico se ha diluido, y están fortaleciendo su posición para formar parte de la arena del “Nosotros” político.

En la Conferencia de Seguridad de Múnich de este año, representantes de grandes empresas tecnológicas fueron ponentes en sesiones sobre las relaciones transatlánticas o medidas para la resolución de conflictos. Fue en esta conferencia sobre política de seguridad internacional en donde Mark Zuckerberg, presidente de Facebook, planteó la necesidad de mejorar el sistema de gobernanza de Internet. Las bases de esa gobernanza: confianza, vigilancia y supervisión, y rendición de cuentas. Para él, las plataformas tecnológicas globales deben ser capaces de responder ante sus errores, y de rendir cuentas ante las personas o grupos afectados. Y para ello, se necesitan estándares que gobiernen la implementación de las tecnologías emergentes –en especial la Inteligencia Artificial, la computación cuántica y los nuevos dominios de la ciberseguridad–, a través un uso responsable de los datos con el fin tanto de minimizar efectos no deseados como de aprovechar las bondades que ofrece. Sin embargo, ¿cuán fácil resulta esto?

Dilemas y limitaciones

Existen varios dilemas y limitaciones regulativas, sociológicas y de seguridad a tener en cuenta. En primer lugar, no hay normas internacionales vinculantes al respecto. Pero, ¿es esta falta de reglas universales un problema? La cuestión no reside tanto en que las haya o no. Más bien, en si tener un paquete global sería algo suficiente e, incluso, necesario. En materia de política digital y tecnológica, el primer paso es regular desde los Estados, no desde lo global. Será a través de las experiencias nacionales y una vez a través del aprendizaje por ensayo y error de las aplicaciones de estas tecnologías lo que nos enseñará hacia dónde deberán virar tales normas internacionales, si es que en el futuro los actores deciden ponerse de acuerdo. Ahora bien, si queremos ser preventivos y protegernos por adelantado, empresas-Estados y Estados-Estados deberían trabajar conjuntamente desde ahora realizando pruebas y simulaciones. Una propuesta es el despliegue de sistemas de Inteligencia Artificial en entornos controlados con el fin de descubrir usos que no se habían pensado nunca, o para preparar mejores protocolos de respuesta ante efectos no deseados. Esto también permitiría tanto a empresas como Estados prevenir mejor problemas legales referidos al principio de extraterritorialidad, o la definición de “daños colaterales” ante el uso de la Inteligencia Artificial en misiones de defensa o inteligencia.

En segundo lugar, el papel de los valores y factores sociológicos en las regulaciones sobre política digital es un activo estratégico que las empresas tecnológicas necesitan (y quieren) tener en cuenta. Mientras que en Estados Unidos los valores son “factores contribuyentes” en las estrategias nacionales, la recientemente publicada Estrategia Europea de Datos demuestra que en la Unión Europea los valores no solamente influyen, sino que más bien son el fundamento, la génesis en sí, de las líneas estratégicas. De hecho, el mercado común europeo de datos quiere que los datos se reutilicen, y que sean interoperables dentro y entre sectores clave. Esta preferencia demuestra que, si la Unión Europea antepone la protección de datos a la competición, las compañías tecnológicas deben entonces orientar su estrategia en esa dirección. No ocurre así en el caso estadounidense, en donde queda todavía mucho por resolver si las empresas quieren asemejarse a los gobiernos respecto a la rendición de cuentas. En especial, debido a la complicada modificación de la Sección 230 del Communications Decency Act, por la cual “ningún proveedor ni usuario de un servicio informático interactivo será considerado editor o portavoz de ningún tipo de información proporcionada por otro proveedor de contenido” . Así, salvo para los casos de circulación de contenido de pornografía infantil, discursos de odio o de naturaleza terrorista, las empresas gozan por el momento de una elevada inmunidad en Estados Unidos por la que difícilmente podrían rendir cuentas ante los efectos dañinos o no deseados por el uso de datos o las tecnologías emergentes.

En tercer lugar, corresponde todavía a los Estados la tarea de proteger sus intereses estratégicos, incluso mediante el recurso a lo digital. Concretamente, las infraestructuras críticas, la competitividad de sus pequeñas y medianas empresas tecnológicas, y la integración de las tecnologías avanzadas en su arquitectura de seguridad, defensa e inteligencia en los niveles estatal, regional y local. Las empresas tecnológicas, a través de su innovación en productos, son claves para refinar las capacidades del Estado a la hora de promover, respetar, proteger y garantizar los derechos fundamentales. Sin embargo, las bondades de las tecnologías también conllevan sin duda grandes riesgos, siendo las empresas quienes deben reducirlos y aliviarlos, y siendo el Estado el encargado de gestionar las crisis ante bloqueos digitales significativos –que ya no bloqueos marítimos, aéreos, u otros dominios– que podrían afectar a las libertades de las personas.

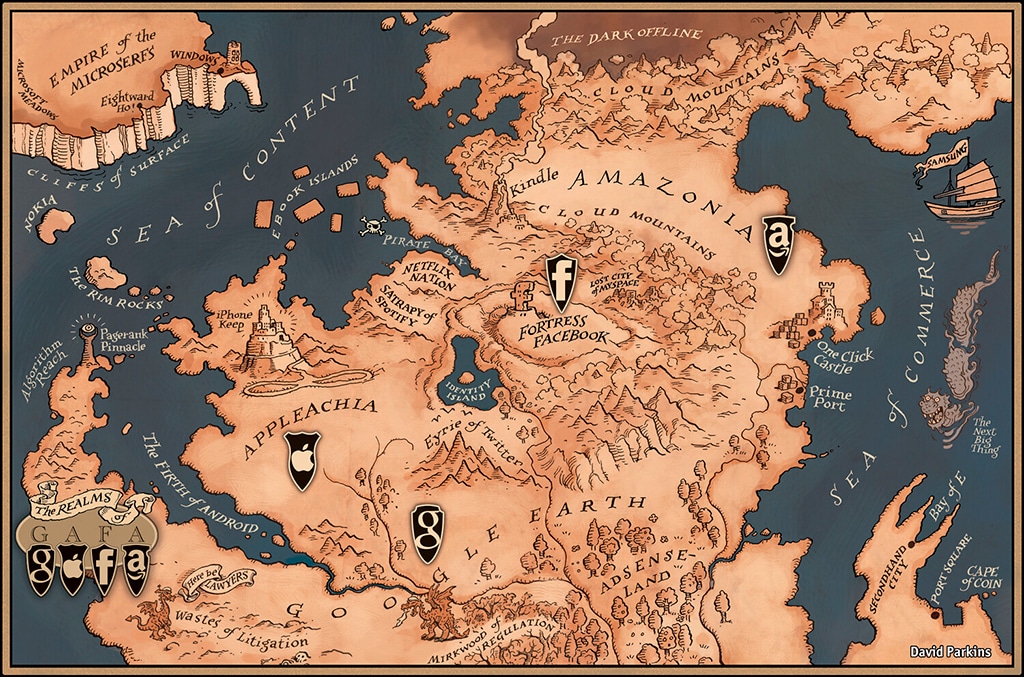

En conclusión, las Big Tech están jugando un papel cada vez más estratégico, de decisión y de marcado carácter geopolítico. Su esfuerzo táctico y de incidencia persiste, pero su voluntad de impacto es más ambiciosa que nunca. Y es algo comprensible: el mundo incorpora sus nuevas tecnologías, y las empresas quieren estar a la vanguardia de lo que todavía está por venir y que ellas van a ofrecer. Así, la cuestión será dónde se encuentra el límite de su participación en el proceso de “policy-making”, cuál debe ser el grado y profundidad de la (necesaria) colaboración público-privada, y en qué medida estos actores –que están en todos los lugares y a la vez en ninguno– podrán responder ante los efectos de lo que ellos mismos quieren atajar. A riesgos diferenciales, políticas diferenciales.